概要

本企画は仮想空間内に作り上げたホールに音源を配置し再生を行うことで自由な位置から音楽を聴取することを可能にした、映像と立体音響による作品制作を通し、その制作手法を検討するとともに音楽×仮想空間×立体音響という新しいコンテンツの可能性を提起する企画である。仮想空間は東京藝大第6ホールのモデルを作成、使用し、作品内では実際の第6ホールの音場再現を試みた。仮想空間ならではの「自由さ」を活かし、現実では体験し難い音楽体験を提供することを目標とした。

第6ホール3Dモデル作成:伊藤優(東京藝大 建築科4年)

一部打楽器3Dモデル作成:吉岡一靖(東京藝大 芸術学科4年)

録音アシスト:澁谷陽奈・吉田羽那・小原幹哉・藪崎友輔・近藤立基(東京藝大 音楽環境創造科プロジェクト音響)

奏者代表:田邉奏貴(東京藝大 器楽科オーボエ専攻4年)

実施報告

本企画は仮想空間内に作り上げたホールに音源を配置し再生を行うことで自由な位置から音楽を聴取することを可能にした、映像と立体音響による作品制作を通し、その制作手法を検討するとともに音楽×仮想空間×立体音響という新しいコンテンツの可能性を提起する企画である。

近年、VRのような仮想現実における技術の進歩はめざましく、多くのコンテンツが公開されているが、映像に焦点を当てるばかりで音、とりわけ音楽に焦点を当てたものは数少ない。音楽に焦点を当てて自由視点を謳ったものもいくつか存在するが、手軽に体験することができる反面、そこに音のリアリティーはないように感じた。そこで、「仮想空間内の演奏をより自由な位置から聴取すること」にフォーカスを当てたコンテンツの制作を行い、その制作手法を考えると共に、立体音響と映像による新しい音楽体験を生み出そうと考え、この企画を応募し実施するに至った。

制作で最初に取り掛かったのは音楽の録音である。楽曲は既存のオーケストラ編成のゲーム楽曲を選択した。これは、あえて既存の楽曲を使用することで、「どの楽曲でもこのコンテンツに落とし込むことができる」ということを主張するためである。録音の奏者は、奏者代表である東京藝大オーボエ専攻の田邉奏貴さんにご協力いただき、他大学を含め、総勢48名の奏者の方にご協力いただいた。私の所属する東京藝大音楽環境創造科のプロジェクト音響の学生5名にも録音の補助でお手伝いいただいた。

録音は東京藝大千住キャンパスのスタジオAにて3ヶ月ほどかけて行った。楽器を狙っているマイクに別の楽器の音が入ってくる「音の被り」を最小限に抑えるために、オーケストラ楽曲でありながらも、クリック(メトロノーム)を聴きながらパートごとに別々に収録を行うオーバーダブの方式を採用した。一部楽器(1stヴァイオリンと2ndヴァイオリン、オーボエとクラリネット)は都合上同時に録音したが、小さな音の被りがどのくらい影響してくるかの検討につながった。最終的に楽器ごとを個別で聴くことができる「ソロ機能」を作品内に搭載したが、全ての楽器を同時に鳴らしている場合は音の被りが気にならず、ソロの状態にするとやはり音の被りが気になる、という程度だったが、作品内での音の色々な扱い方を考えると、音の被りにはかなり気をつけて収録をした方が良いことがわかった。

マイキングについては、距離減衰等の空間に関わる処理を後に紹介するWwise(ワイズ)を使用して設定していくため、音が強く放射する位置からなるべく近い位置にマイクを設置した。1つの楽器につき複数の楽器で収録するのが理想だが仮想空間に配置する音源が多くなるほど処理が重たくなるため、音が放射する方向によって音の周波数が大きく異なる楽器や体が大きい楽器(ファゴット、オーボエ、ピアノなど)以外は1つのマイクを使用して収音している。この制作のためだけではなく、音楽のみの単なる立体音響作品の制作にも使用できるよう、アンビエンスマイクも複数配置して収録を行った。

今回の録音方法によって音の被りは最小限になり作品のクオリティは担保することができたが、楽器の数によっては時間と日数を要するため、コストがかかることが課題として挙げられる。録音の方法については、遮音板を違う楽器の間に立てたり、演奏する位置を極端にずらして録音してみたりなど、同時に演奏しながらも音の被りを最小限に抑える方法がいくつか考えられる。しかし、その録音方法がいい演奏につながるとは限らないため、良い塩梅を探して検討していきたい。

次に仮想空間のモデルの作成に取り掛かった。仮想空間に現実の模したホールを使用することは当初から考えており、東京藝術大学の第6ホール(以下6ホール)を仮想空間に落とし込みたいと考えていた。構想段階では藝大の所有するMatterportやiPhoneを用いたLiDARでの撮影によってモデルを作成することを考えていたが、メンターである芸術情報センター特任講師の秋田亮平先生の助言のもと、すでにデータとして存在していた6ホールの点群データを元に新たにモデルを作成することとなった。これは点群データのままでは撮影しきれていないとても細かい部分が再現しきれない、新たにライティングすることができない、椅子や照明などの物体を移動することができないなどの障害が生じるためである。モデルの作成は、建物をモデルする際などに使うCADソフトなどを日頃から学習している東京藝大建築科の学生である伊藤優さんに作成していただいた。ソフトはRhinocerosを使用している。

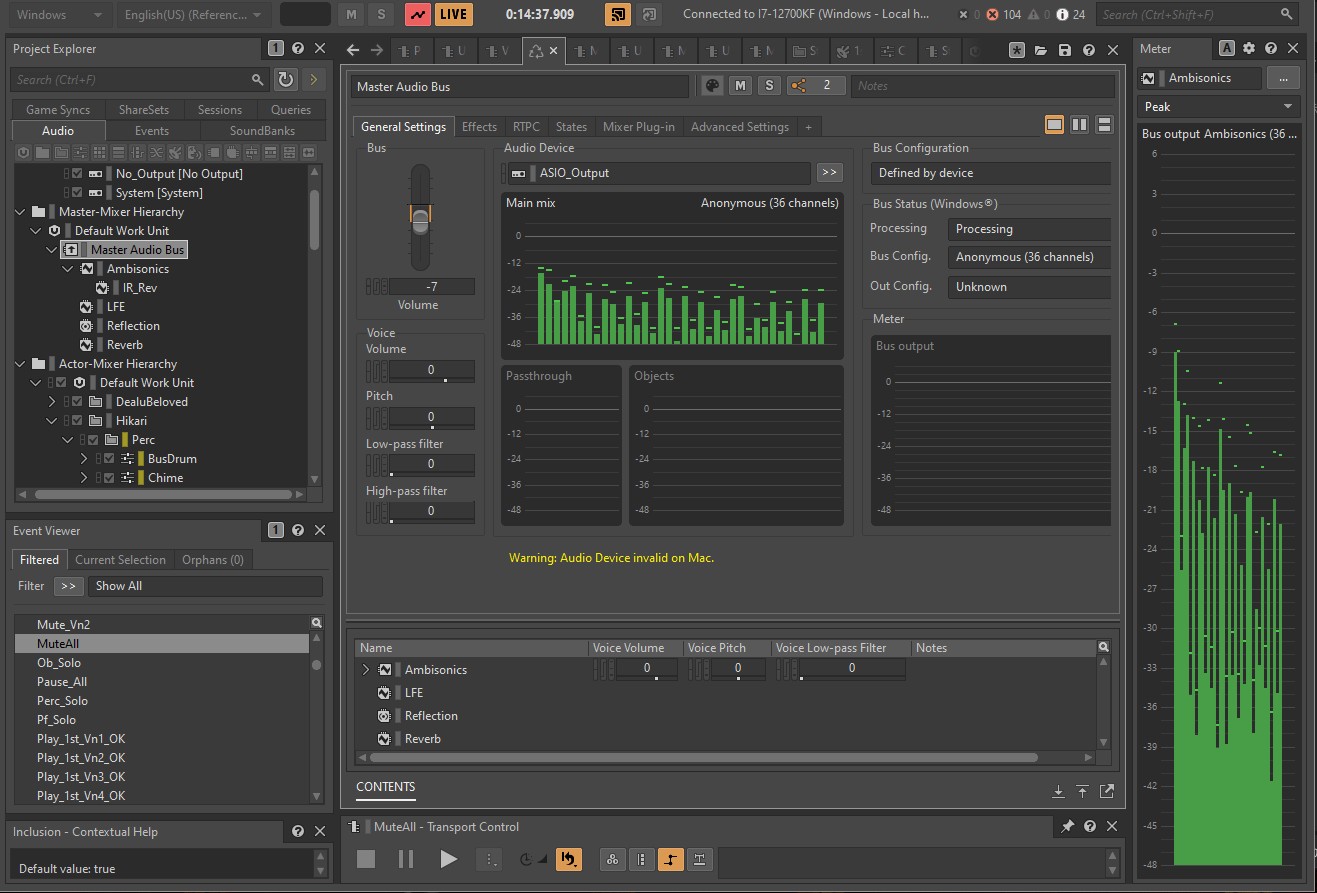

6ホールのモデル制作と同時並行でサウンドの制作と制御に取り掛かった。サウンドの制御は、オーディオミドルウェアのWwiseを使用した。構想当初からマルチチャンネルでの立体音響を想定していたため、7.1.4ch以上のスピーカー配置に対応しており、オーディオの管理や音の設定が効率的に行えるWwiseを採用した。Wwiseでは7.1.4chや13.1chといったスピーカーコンフィグ以外にも、最大5次までのAmbisonics信号にエンコードして出力することも可能になっている。従来のスピーカー配置にとらわれず、下方からも音を出力することでより空間の再現性が増すと考え、360°方向からの音声情報を記述するAmbisonics方式を使用することにした。今回はWwiseからのAmbisonics信号をDAWであるReaperに送り、プラグインであるIEM Plug-in SuiteのAllRADecoderでデコードをし、スピーカーに出力した。

サウンドの処理では、①音の距離減衰 ②楽器の放射特性 ③音の透過 ④音の回析 ⑤反射音 ⑥残響 に対しての設定を行った。

①については「点音源においては距離が2倍になれば6dB減衰する」という理論を参考に音の距離減衰を設定した。ただし、あくまで点音源の場合の理論値であるため、録音時に同時に撮影を行った動画や聴感の記憶を頼りに調節している。②については、特に放射特性の鋭い楽器(トランペットやトロンボーンなど)には後ろに回り込んだ際に高域が小さくなるといった簡易的な設定をしている。③〜⑥では実際の6ホールの音響特性に則った設定を試みた。音の反射はホールの3Dモデルの形に合わせて二次反射音までリアルタイムに計算をさせている。ただし、ホールの形完璧に合わせると処理落ちしてしまうため、かなり簡易的な形で反射するようになっている。

残響は6ホール建設当初に測定したデータに基づいて残響時間を設定。残響の情報を記録するインパルス応答の収録をAmbisonicsの方式で行いたかったが叶わなかったため、記憶を頼りに聴感で音色を決めた。仮想空間の配置やライティング、プレイヤーの操作設定など、サウンド以外のものはUnreal Engine5(以下UE5)を用いて作成を行った。仮想空間内の操作は、PCにPlayStationのコントローラーを接続することで行った。プレイ中の視覚による面白さ、わかりやすさを考慮し、楽器は音の大きさに連動して動くようになっている。新しい音楽体験のための「自由さ」を追求するため、「しゃがむ」機能や、現実には不可能な「飛行」機能を用意し、楽器の下から上から、好きな位置から音楽を聴くことができるような仕様に設定を行った。他にも、少しゲーム的な要素を取り入れ、前述したように楽器を個別で聴くことができるように個々の楽器を1つずつソロで聴くことができるようにした。

制作した作品は2023年度の東京藝大音楽環境創造科発表展「千住Art Path2023」にて、360°取り囲むように設置された27.2chのマルチチャンネル作品として東京藝大千住キャンパスのスタジオBで2023年12月16日、17日の二日間の公開を行った。これが本作品の初公開である。千住Art Pathでは約160名の方に作品を体験していただき、多くの感想をいただいた。楽器の裏や指揮者の位置など、好きな場所で音楽を聴くことができることや、特に空を飛ぶことで現実には不可能な位置から音楽を聴く新鮮さがよかったというコメントが多く、本制作の目標を概ね達成した完成度であったといえる。

2024年3月16日、17日に行われた「ART DX EXPO #1」では、従来の7.1.4chのスピーカー配置に下層の4chを四角に配置した7.1.4+4chのマルチチャンネル作品として、東京藝大上野キャンパスのアーツ&サイエンスラボ4F球形ホールにて、3月16日のみ公開した。人数統計をとり忘れてしまったため、人数は定かではないが、千住Art Pathの時と同様のコメントをいただくことが多かった。

最後に、本企画を通しての考察である。作品を制作していく上で、このコンテンツの使い方について考える機会が多くあった。当初の目的の通り新しい音楽体験を提供するコンテンツとして使用することはもちろんであるが、音響的な面をさらに詰めていき、音場再現の精度をあげることができれば、録音時に空中に吊るメインマイクのシミュレーションや、建物の音響をアーカイブするといったことにも応用することができるのではと考えている。特に建物の音響を仮想空間にアーカイブすることは今までにあまり例の無い取り組みであるため、この制作によって新しい方法を提案することができるのではないだろうか。

上記二つの発表をもって本企画は終了となったが、今後も音響的側面からこのコンテンツ制作をさらに進め、デジタルの力で世の中がより豊かになるよう研究を進めていきたい。

- 松村道知

-

東京藝術大学音楽学部音楽環境創造科4年に在学、亀川徹研究室に所属。

音と映像によって成立するコンテンツの制作に興味を持ち、レコーディング、ミキシング、サウンドデザイン、ゲームの制作などを行う。

現在は仮想空間内での自由視点と自由聴点を可能にした新しい立体音響コンテンツの制作に着目し、その制作手法の検討や、人と映像と立体音響の関係についての研究を行っている。